ニュース

CGキャラと触れあえる? 未来のゲームに応用できそうな「インタラクション技術」をSIGGRAPH 2014展示会場でチェック

|

今回は,ゲームに応用されると面白そうな技術を集めてみた。未来のゲームに使われるかもしれない技術を一足先にチェックしてみよう。

空中に表示したユニティちゃんをグルグル回す

HaptoMIRAGE

「ゲームのキャラクタと直接触れあたらいいのに」なんてことを考えたことはないだろうか。仮想世界のCGオブジェクトを現実世界に出現させて,それとインタラクションするインタフェース技術の開発は,SIGGRAPHでは人気の研究テーマだ。

慶應義塾大学メディアデザイン研究科大学院に所属する上田雄太氏らの研究グループが開発した「HaptoMIRAGE」は,まさにそういった願望を実現するための技術となるかもしれない。ちなみにHaptoMIRAGEとは,「無形物であるはずのCGに触れる」とコンセプトから“触れる”(Hapto)と“幻影”(Mirage)という単語を組み合わせた造語とのことだ。

まずは公式の解説動画を見てほしい。

Hapto Mirage from ACM SIGGRAPH on Vimeo.

HaptoMIRAGE研究グループが出展したブースでは,ゲームエンジン「Unity」のマスコットである「ユニティちゃん」の立体映像が,透明アクリル製の小さな箱の上で踊っているというデモが披露されていた。ユニティちゃんは箱から投影されているわけではなく――箱の中はからっぽだ――空中に表示されているので,デモの体験者はまずそれに驚かされる。

|

|

| 箱の上で踊るユニティちゃんの立体映像。サイズは10cm強くらいだ。実体のないCGなので,ピントをうまく合わせられなかったことはご容赦を | |

空中のユニティちゃんはCGだが,箱は実在の物体だ。来場者が箱を左右に回転させると,ユニティちゃんも箱の上に乗っているかのように回転と同期して動き,体験者が横に回り込んだりすると,ユニティちゃんが踊る姿を横から見られるといった具合だ。

さらにこのデモは,3人までが同時に体験できるという。ユニティちゃんの正面にいる人には,正面から見たユニティちゃんが見え,左右にいる人からは,横位置のユニティちゃんが見えるのだ。

直接CGに触っているわけではないが,体験としては自分の手でCGの立体映像を動かしているのに近い。無形の情報に人が触れる技術「Tangible Bit」タンジブル・ビットというのは,こういう概念なのかなと思わされた。

|

|

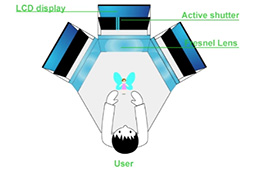

1つめは,CGを出力するための液晶ディスプレイだ。といっても,特殊なディスプレイは必要ない。会場で使われていたのも,DELL製のありきたりなPC用22インチ液晶ディスプレイだった。

2つめは,裸眼立体視を実現するために必要な視差マスクを動的に作るための透明液晶パネルだ。透明液晶パネルは,映像表示用の液晶パネルと同じサイズと解像度を持つが,映像を表示するのではなく,ピクセル単位で光の透過・不透過を制御するために使われているという。

一般的な裸眼立体視ディスプレイでは,液晶パネルの前面に,パターンが固定された視差マスクを貼り合わせている。しかしHaptoMIRAGEでは,観測位置が変化するうえに最大3人分の視差マスクが必要になるため,固定パターンの視差マスクは使えない。そこで,パターンを動的に変更できる視差マスクを作るために,ディスプレイとは別に液晶パネルを使っているのだ。

|

HaptoMIRAGEはこれらを3セット用意して,体験者を取り囲むように設置していた。これにより,視野角150度で空中に立体像が表示できる多視点裸眼立体視を実現できるというわけだ。

体験者の位置認識には,HaptoMIRAGEの中央上部に設置されたXbox One用の新型Kinectセンサー(以下,Kinect)が利用されている。

そのため,同時に体験できるのが3人までというのは,Kinectの認識能力による制限なのかと考えて上田氏に聞いてみたところ,そうではなく,動的視差マスクを生成させる透明液晶パネルのリフレッシュレートによる限界なのだそうだ。

現在のシステムが使う透明液晶パネルは,リフレッシュレート60Hzという一般的なもの。より多くの人数に対応する動的視差マスクを作り出すには,より高いリフレッシュレートのものが必要になるという。つまり,視差マスク生成用の透明液晶パネルに,高リフレッシュレート対応のものを使えば,さらに多くの人数で同時体験が可能になるわけだ。

なお,HaptoMIRAGEはユニティちゃんを動かすだけでなく,Kinectの高精度な深度センサーを利用して,空中に絵を描くという機能もある。残念ながら,筆者が訪問したときには機材トラブルでこれを体験できなかった。先に掲載した動画にはそのデモが収録されているので,その意味でもぜひ見てほしい。

HaptoMIRAGEは,CEDEC 2014でも披露される予定とのこと(関連リンク)。来場予定のある人は,機会があれば体験してみてほしい。

CGキャラクタと超音波で手をつなげる触角再現技術

HORN:The Hapt-Optic Reconstruction

CGオブジェクトとのインタラクション分野で近年流行しているのは,Kinectのようなモーション入力を使ったシステムだ。しかし,モーション入力システムは,「手応え」がないという問題点を抱えている。いまどきのゲームパッドは,ブルブルと振動して「攻撃を受けた」とか「何かにぶつかった」ときに手応えを与えられるのが当たり前なのに,モーション入力ではそれができない。

この問題を解決すべく,Haptics(触覚)技術を使って触感を再現するモーション入力の研究開発が,各地で進められている。SIGGRAPH 2013のE-TECHレポートで紹介した,Disney Researchの「AIREAL」(エリアル)もそうした研究の1つだった。

東京大学大学院情報理工学系研究科の井上碩氏らが開発した「HORN」も,触角を再現したモーション入力システムである。

|

粘りけのある触感を表現できているのには驚かされた。実体のあるなにかに触れたわけでもなければ,なにか特殊な手袋をはめているわけでもないのに,手に触感が伝わってくるのだから,なんとも不思議だ。

球体に指で触れると,ビヨンビヨンと形が変わるので,本当に自分の指がCGオブシェクトと相互に触れあっているような気分になる。接触に応じて球が近づいたり遠ざかったりもするのも凝っていて面白い。公式の解説動画も掲載しておこう。

Horn from ACM SIGGRAPH on Vimeo.

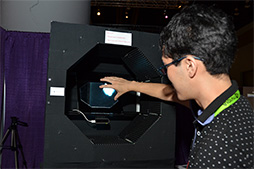

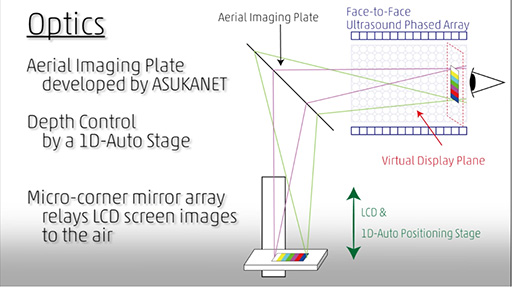

どのような仕組みで,HORNのシステムは実現されているのだろう。まず

映像自体は,舞台の下側に設置された液晶ディスプレイに表示したものを,ハーフミラーに投影させる方式だ。ハーフミラーは映像を半透過・半反射するので,鏡像が飛び出しているように見える。この仕組みは昔からあるもので,デジタルサイネージ用途でも使われることがあるとのこと(関連記事)。

HORNが凝っているのは,液晶ディスプレイを上下させる仕組みを組み合わせたことにある。液晶ディスプレイを上下させるとハーフミラーとの距離が変わるので,体験者から見た鏡像が,近づいたり遠ざかったりして見えるというわけだ。

|

一方,手の動き検出には,PC用モーションセンサーではよく知られた「Leap Motion Controller」を採用している。特別な使い方はしていない。

一番重要なのは,触覚再現にどのような仕組みを採用しているかだ。Disney ResearchのAIREALではこれに,空気渦を体験者に浴びせる“空気砲”的な仕組みを採用していた。HORNではこれに,超音波を使う。つまり,E-TECHレポートのディスプレイ編でもたびたび登場した名古屋工業大学の星 貴之氏による小型の超音波発生装置と,同じ原理で触覚を感じさせているのだ。

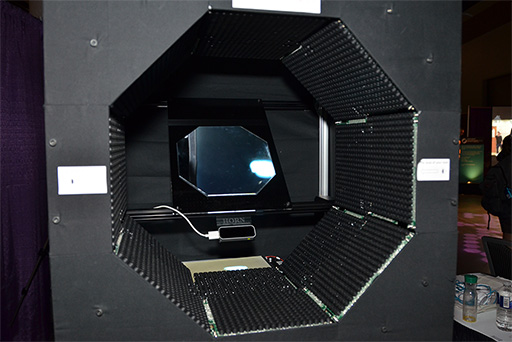

HORNでは,手を入れる開口部の形状が八角形になっていて,その各面に超音波発生装置が取り付けられている。超音波発生装置1台には,超音波を発生させるユニットが縦14×横18の計252個搭載されており,八角形の各面には,この装置が2台取り付けられていた。つまり,252基×2台×8面で,4032基の超音波発生ユニットで触感を表現しているのである。

ちなみに,装置が発生する超音波は周波数40kHz。これを8面すべてから放射することで,手指の表,裏,側面に対して正確に触感を与えられるとのことだ。

|

筆者も驚かされた粘性のある触感の再現は,超音波の強弱を時間軸方向に変調させることで実現しているという。対象物(CGオブジェクト)に指が近づくと強い超音波で強い圧力を発生させ,離れると圧力を弱めるという手法なのだそうだ。

さて,空気渦を使ったDisney ResearchのAIREALと比べて,超音波を使ったHORNには,どのような優位性があるのだろうか。筆頭研究者の井上碩氏は,3点を挙げて説明する。

1つは振動表現を与えるまでの遅延が短いこと。空気渦を使うAIREALは,空気そのものを移動させているので,渦が空気中を伝わる速度は7.2m/sと遅い。つまり,体験者が何かに触れてから,その反応が空気渦として再現されるまでに時間がかかってしまう。

それに対して超音波を使うHORNなら,出力するのは音波であるから,約340m/sで伝わり,速度差は歴然というわけだ。

2つめは,超音波を使うので遮蔽に強いこと。超音波は「波」なので,障害物があっても回折して伝わる。だが,空気流は遮蔽物があると,そこで遮断されたり拡散,分解してしまう。

3つめは,表現できる刺激や触感の“解像度”が空間的にも時間的にも高いこと。AIREALは空気渦を使っているので,飛ばす距離が長いと拡散してしまい,意図したとおりの触感を再現できない。だが,超音波ならビーム状に絞って出力できるので,HORNのシステム程度の距離なら拡散は無視できるし,波動を収束させて一点に集中させることで,刺激を表現することも可能だ。しかも,刺激の強弱を音の高低で表現できる。デモでは実際に,粘性の触感表現に強弱の変化を使っているのだそうだ。

現在のHORNはやや仰々しく,かなり巨大なシステムとなっている。だが,これを小さいシステムで構成できるようになったとしたらどうだろう? CGキャラクターと手をつないだり,体に触れたりといった表現が可能になるかもしれない。

自律飛行が可能な超小型クアッドコプター

Above Your Hand

4基のローター(回転翼)を備えた小型のラジコンヘリ「クアッドコプター」が人気だ。安定した飛行が簡単にできることに加えて,最近では積載能力も向上している。ハイアマチュアの世界では,本格的な空撮を楽しむ人も急増中だ。

|

研究チームはPhenox Lab(フェノクス・ラボ)というベンチャー企業を設立して開発に取り組んでおり,そのプロジェクトは独立行政法人情報処理推進機構の「未踏IT人材発掘・育成事業」の2013年度採択プロジェクトにも選ばれているという。

Above Your Hand from ACM SIGGRAPH on Vimeo.

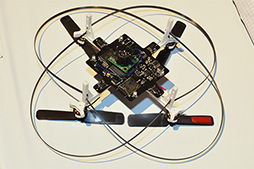

全長は約12cm(※ローター長は含まず)で,重量は約70gしかない。大人の手の平に余裕で乗る程度のサイズだ。

しかし,小さいだけが特徴ではない。Above Your Handのポイントは,人間が随時操作するラジコンではなく,自律飛行ロボット(ドローン)であること。そのために,高度な処理能力を備えるコンピュータを搭載している。

4層基板のメインボードには,Xilinx製のSoC(System-on-a-Chip)である「ZYNQ-7000」ファミリを2基と,映像処理プロセッサ用として別のFPGAを1基搭載しているという。メモリには容量256MBのDDR3 SDRAMを採用し,ストレージとしてmicroSDカードスロット,無線通信用にBluetooth通信機能も装備。これらを動かすためのバッテリーも搭載している。ちなみに,OSはLinuxベースの「Ubuntu」とのこと。

機体の下部と側面にはカメラが装備されており,地面との距離を測る超音波測距センサーもある。とくにホバリング時の安定性確保に,超音波測距センサーが活躍するという。また,マイクも搭載されているので,音声コマンドによるコントロールにも対応可能とのことだ。

|

|

Above Your Handは,搭載するアプリケーションを入れ替えることで,さまざまな自律飛行プログラムを実行できるというのが特徴となっている。SIGGRAPH 2014で披露されたデモ機は,特定色の手袋をはめた手をクアッドコプターに近づけると,それをカメラで認識してその場でホバリングしたり,手を振った方向に向かって飛んでいったりと,キャッチボールのような動作をするアプリケーションが動作していた。

飛行性能の範囲であれば,ソフトウェア次第でどんなこともできるので,ユーザーから一定距離離れたら,その人物を撮影して戻ってくるといった,ある種の「自撮りアプリ」程度は,容易に実現できると説明員が解説していた。

映像処理FPGA部分はコンピュータビジョン用プログラミングAPI「OpenCV」に対応しており,高度な画像認識プログラムを実行させる能力があるという。画像認識機能と音声入力機能を活用すれば,歩きながらしゃべる自分を追従し続ける,ハンズフリーの自撮りライブ中継なんてことも可能だそうだ。

このAbove Your Handシステムは,Kickstarterを利用して30台限定で販売されたことがある。ただし,今のところ量産化の予定はないそうだ。ただし,問い合わせは着々と増えているそうなので,いずれ何らかの形で要望に応えたいと担当者は述べていた。

遮蔽と無縁な電磁式モーション入力システム

IM3D

KinectやLeap Motion Controllerのような赤外光を使った光学式モーション入力システムでは,体の部位同士が重なる遮蔽に弱いという問題点がある。たとえば,両手の指をトラッキングしているときに指同士が重なり合うと,各指の状態を一瞬見失ってしまう。そのため,遮蔽によって瞬間的に動きを検出できなくなった場合は,「起こりうる指の動き」の知識モデルをもとに,動きを推測してトラッキングを続けるというのが一般的な手法だ。

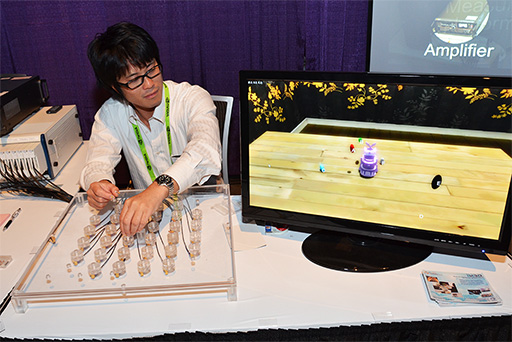

遮蔽に影響を受けないモーション入力システムというのは,実現できないものか? 東北大学のJiawei Huang氏らが開発した「IM3D:Magnetic Motion Tracking System for Dexterous 3D Interactions」(以下,IM3D)こそ,まさにそうした存在だ。

IM3Dは,全長わずか15mm,重さ1gの電磁気マーカー(以下,マーカー)を使った,遮蔽に影響を受けない電磁式のモーション入力システムであり,光学式モーション入力システムが抱える課題を解決することを目指している。

SIGGRAPHのブースに用意されたIM3Dのデモは,体験者の指にマーカーを付けてセンサーを配置したテーブルの上で動かすと,CG世界のオブジェクトをつまんだり,移動させたりできるというものだった。指が複雑に動いて折り重なったとしても,正確にマーカーの位置をトラッキングできることを,オブジェクトの動きで確認できるというわけだ。

|

IM3D from ACM SIGGRAPH on Vimeo.

|

|

|

| IM3Dのマーカー(左)。その実体はフェライトコアに電線を巻いたコイル。書かれている番号はIDに相当し,共振周波数の違いで個々のマーカーを識別する仕組みだ。右写真はマーカーを指に貼り付けた状態 | |

テーブル側には32個のアンテナコイル(センサー)があり,マーカーが発生する磁気によって,今度はセンサー側に誘導電流が生じる。各マーカーのLC共振回路は固有の共振周波数を持っているので,その周波数から「どのマーカーが近づいたのか」を正確に判別できるというわけだ。

電流の強弱からは,マーカーとセンサーの距離が分かり,複数のセンサーが取得した誘導電流の周波数と電流の状態から,マーカーの回転状態(=向き)も判別できるのだそうだ。

テーブルの下にある飴玉のような物体が,マーカーの接近を感じ取るセンサー部だ。数は32個ある |

写真下側の計測機器が,32個のアンテナコイルから取得した電流を計測している。上の機材は信号を増幅するアンプ |

IM3Dが検出可能な動きの精度は,なんと1mm未満。テーブル上の位置によっては5mm未満になってしまう場所もあるそうだが,誤差を補完する技術を組み合せることで隠蔽できるという。

そんなIM3Dは,どのような用途に応用できるだろうか。折り重なった指を検出でき,しかも動きを繊細に記録できるので,いろいろな用途を研究チームでは考えているようだ。

たとえば,紐の結び方や折り紙の折り方,粘土細工の作り方に楽器の演奏など,複雑かつ細かい指の動きが重要なものに使うというのが考えられるだろう。その分野の名人技を記録しておくというのも面白そうだ。あるいはもっとシンプルに,CG制作時のモーションキャプチャやパフォーマンスキャプチャにも利用できるかもしれない。

ただし課題もある。「光学式モーション入力システムと比べると,システム構成がやや仰々しいこと」と「電磁気を利用しているので,磁気を持ったものや金属からの干渉に弱い」といった点を,担当者は挙げていた。そうなると,やはりコンシューマーが家庭で使う入力装置というよりも,管理された環境でプロがモーションデータ制作に使うという装置,といった使われ方が妥当だろうか。

なぜか引っ張られちゃう不思議な振動モジュール

Buru-Navi3

|

それは,カーナビや歩行者用ナビシステムのように映像や音声で進むべき方向を指示するのではなく,「引っ張る力」で進むべき方向を指示するというデバイス「Buru-Navi3」というもの。CS研では,将来的にはこれを携帯電話機内に搭載することで,画面を見なくてもユーザーを目的地に誘導できるようにすることを狙っているという。

引っ張る力といっても,本当にBuru-Navi3が人間を引っ張るわけではない。人間の錯覚を応用して,引っ張られているように感じさせるのだ。

|

クランクバーを等速で往復運動させるのではなく,牽引力を発生させたい方向(=引っ張る方向)に対して非線形な加速度で動かすのだ。クランクバーの往復運度によって発生する力は,エネルギー的には往路と復路で等しいはずなのだが,Buru-Navi3を持った人間は,力が強くかかった方向(加速度が大きい方向)に引っ張られたように錯覚するのだという。

モーターとクランクバーのセットが1つだけだと,前後あるいは左右といった2方向,一次元の引っ張る力しか表現できないが,2セットあれば二次元平面で任意の方向に引っ張る力を作り出せる。これによって,Buru-Navi3は人間に引っ張られているような力を感じさせるというわけだ。

公式動画も掲載しておくので,ぜひ見てほしい。

|

|

| 1つのクランクバーでは,左右2方向へ引っ張る力しか表現できない(左)。2つ組み合わせれば,任意の方向に引っ張る力を表現できる(右) | |

Buru Navi3 from ACM SIGGRAPH on Vimeo.

|

1つめはBuru-Navi3の基本機能を体験するデモだ。体験者は,先に掲載したBuru-Navi3のデバイスを指で持ち,引っ張る力を直接体験する。引っ張る方向はタブレット上に表示されたボタンを押して指示するという仕組みだった。

2つめはゲーム的なフォースフィードバック機能を体験するデモだ。ゲームパッドに振動機能を内蔵するものは珍しくもないが,Buru-Navi3では特定の方向に向けた引っ張る力を再現できるため,ゲーム内容とうまく連動すれば臨場感を一層高められるだろう。

|

ゲーム風の魚釣りデモは,釣り糸を魚が引っぱる感触が伝わってくるので,単にタイミングを合わせるだけの釣りゲームよりも楽しめる。2つのデモを撮影した動画も掲載しておこう。

3つめは,スマートフォンにおける地図アプリでの歩行者ナビゲーションを想定したデモだ。Buru-Navi3が取り付けられたデバイスを手に持つと,任意の方向に引っ張られるので,その方向指示に合わせて歩くという内容であった。

「どの程度の牽引力をどの方向に感じるか」は個人差があるとのことなのだが,筆者はつんのめりそうになるほどの力を感じて,設定したルートどおりに歩くこととなった。

|

当時は,両手持ちのとても大きなものだったのだが,Buru-Navi3ではもう少しで携帯型デバイスに内蔵できそうなサイズまで小型化されたというわけだ。

携帯電話機に内蔵できる歩行者ナビ支援機能を目指して開発されたBuru-Navi3だが,特定方向にフォースフィードバックを与えられる特徴を活かして,ゲームパッドに内蔵してみると面白いのではないだろうか。

たとえば,敵に吸い込まれたり弾き飛ばされたりするときに,画面上の動きに合わせてゲームパッドが引っ張られる感覚で表現すると,ただの振動とは違った臨場感があるはずだ。あるいは,下方向に引っ張って重くなった表現を,上方向に引っ張って浮いていくような表現なども可能であろう。

引っ張りの力を表現するときは非線形加速度運動をするわけだが,これを等加速運動にすれば普通の振動も表現もできるわけで,一石二鳥だろう。スマートフォンへの内蔵を目指しているくらいだから,そのサイズを実現できれば,ゲームパッドに入れることも難しくなさそうに思える。

ぜひとも早期の実用化を期待したい。

もうひとつの牽引力発生デバイス

Traxion

E-TECH会場ではもう1つ,東京大学大学院情報学環の暦本純一教授の研究室が開発した牽引力発生デバイス「Traxion」も出展されていた。

|

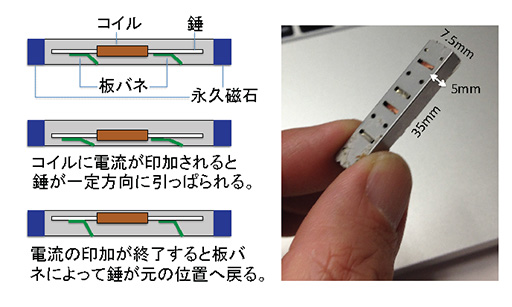

Forcereactorの内部には,錘付きのコイル(電磁石)と板バネが入っている。コイルに電流が流れると錘は板バネに引きつけられ,電流が弱まると板バネの反発力で跳ね戻される。この動作を繰り返すことで振動を作り出すというものだ。任天堂のゲームパッドで振動ユニットに採用されたこともあるという。

|

このように,Forcereactor自体は振動を発生するためのデバイスなのだが,暦本研究室がコイルに与える電流パルスのオン・オフを工夫することにより,Forcereactorで大きな加速度と小さな加速度の組み合わせを特定方向に発生させられることを発見する。

Buru-Navi3でも述べたように,人間は大きな加速度を感じると,そちらに引っ張られたように錯覚するので,Forcereactorでも仮想的な牽引力が発生できるというわけだ。Traxionはその原理を応用したものである。

Traxion from ACM SIGGRAPH on Vimeo.

ちなみに,振動周波数はTraxionが大体120〜200Hz程度で,Buru-Navi3が40〜70Hz程度となっている。どちらが優れているかは分からないそうで,むしろどのような機器に組み込んでどう使うかによって,どちらが適するのかを模索している段階だということのようだ。

Forcereactorはゲームパッドでの採用事例もあるだけに,ゲーム分野での応用も期待できそうで,ぜひ実現してほしいところである。

Emerging Technologies|SIGGRAPH 2014

SIGGRAPH 2014 公式Webサイト

- この記事のURL: